Scrapy Shell是一个交互式命令行工具scrapycssxpath区别,用于测试CSSXPath选择器提取数据它可以帮助开发者快速定位页面元素并提取所需数据编写Spider使用CSSXPath选择器定位页面元素scrapycssxpath区别,并提取所需数据存储数据可以使用Feed exports等功能创建请求快捷方式如使用responsefollow等方法简化代码,提高开发效率传递Spide。

Scrapy是一个用于网络信息请求与提取scrapycssxpath区别的强大工具,要熟练使用Scrapy,了解网页scrapycssxpath区别的结构和如何有效提取信息是基本前提一URL简介URLUniform Resource Locator,统一资源定位符,是互联网上的标准资源地址表示每一项互联网资源都对应一个唯一的URL,URL分为两部分,首部解析定位目标主机,第二部明确请求主机。

1 Beautiful Soup 客观的说,Beautifu Soup不完满是一套爬虫东西,需求协作urllib运用,而是一套HTML XML数据分析,清洗和获取东西2Scrapy Scrapy相Scrapy, a fast highlevel screen scraping and web crawling framework for Python信不少同学都有耳闻,课程图谱中的许多课程都是依托Scrapy抓去。

其次,理解并区分quotnode1quot与quotnode1quot的区别,这是Python语言中常见的语法差异再次,对于使用类名进行查找,推荐优先考虑CSS选择器,因为CSS选择器通常更为简洁且易于理解,尤其是当一个元素包含多个样式时本篇文章旨在全面介绍Scrapy选择器的使用方法与注意事项,以供开发者深入学习与实践。

Pyspider的一大优点是其直观的Web UI,使得调试过程更为便捷,相比之下,Scrapy主要依赖于parse命令进行调试,便利性略逊一筹Pyspider内置PyQuery作为选择器,而Scrapy则支持XPathCSS选择器和正则表达式,灵活性更强对于快速抓取普通新闻网站这类需求,Pyspider的开发效率更高,如获取某个新闻网站的内容。

Pyspider和Scrapy的区别主要包括以下几点调试便利性Pyspider具有直观的Web UI界面,使得调试过程更为便捷Scrapy主要依赖于parse命令进行调试,相比Pyspider的Web UI,便利性略逊一筹选择器灵活性Pyspider内置PyQuery作为选择器,选择方式相对固定Scrapy支持XPathCSS选择器和正则表达式,选择器。

Scrapy是Python中一个强大且高效的网络爬虫框架其主要特点和优势如下高效爬取Scrapy提供了高效的爬取机制,能够快速地抓取大量网页数据灵活数据提取通过其内置的选择器和XPathCSS选择器,Scrapy能够灵活地提取网页中的所需数据自动化流程控制Scrapy具有强大的自动化流程控制能力,可以方便地管理。

XPath选择器是Scrapy中不可或缺的工具,用于精确地定位和提取网页中的特定信息例如,在抓取网页中的标题时,XPath选择器发挥着关键作用数据验证实战演示后,需要查看实际的输出结果,确认是否成功抓取到了所需的数据这个过程旨在确保Scrapy的正确应用,以及数据的准确性Scrapy框架为Python开发者提供了。

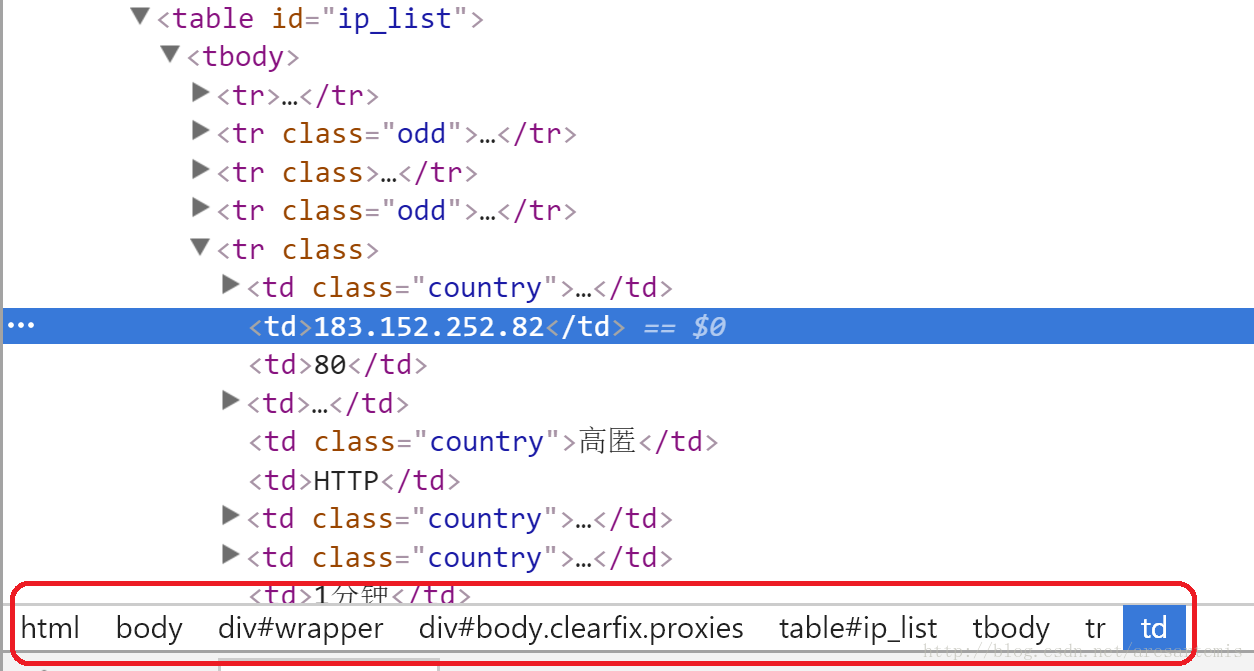

Scrapy,一个基于Python的开源Web爬虫框架,专为复杂网络环境设计,处理登录过滤重复存储等常见问题构建Scrapy爬虫涉及项目创建爬虫类定义URL初始化逻辑与解析规则设定,实现从数据中提取所需信息的自动化流程数据解析借助CSS选择器与XPath选择器,高效过滤并提取网页内容,满足不同数据结构需求。

一Scrapy框架爬虫的核心特点 高效性Scrapy框架支持并发请求,可以显著提高爬虫的运行效率可扩展性Scrapy提供了丰富的组件和中间件,用户可以根据需求进行自定义扩展结构清晰Scrapy框架遵循特定的项目结构,使得代码更加清晰易于维护强大的数据解析能力Scrapy支持多种数据解析方式,如XPathCSS。

在parse函数中,使用XPath或CSS选择器获取详情页链接,并将其传递给parse_detail函数在parse_detail函数中,定位到详情页中的图片元素,并提取src属性以获取高清图片URL配置图片下载在pipelinespy文件中,引入Scrapy的ImagePipeline配置ImagePipeline以处理图片下载任务设置项目配置在settingspy文件。

使用选择器提取元素,例如 CSS 或 XPath处理表单gchoose_form0 # 选择表单 #39field_name#39, #39input_value#39 # 设置输入字段 # 提交表单 实践尝试抓取新闻网站的头条新闻,打印标题和链接确保遵循目标网站的 robotstxt 文件和使用条款总结,Grab 是。

常用的手段是通过xpath或者css选择器从DOM中进行提取,而且学习这项技能在几乎所有的爬虫框架中都是适用的数据处理,普通的爬虫程序中是把网页解析器和数据处理器合在一起的,解析到数据后马上处理 在一个标准化的爬虫程序中,他们应该是各司其职的,scrapycssxpath区别我们先通过解析器将需要的数据解析出来,可能是。

2 数据提取 XPath解析器scrapy内置XPath解析器,通过response对象调用,使用extract等方法提取数据例如,responsexpath#39extract_first可以获取网页标题的第一个匹配项3 日志管理 日志级别scrapy有5个日志级别,包括DEBUGINFOWARNINGERROR和CRITICAL,分别对应不同严重程度的日志信息。

一般获取数据的过程都是按照 发送请求获得页面反馈解析并且存储数据 这三个流程来实现的这个过程其实就是模拟了一个人工浏览网页的过程Python中爬虫相关的包很多urllibrequestsbs4scrapypyspider 等,我们可以按照requests 负责连接网站,返回网页,Xpath 用于解析网页,便于抽取数据2了解非。

相比之下,xpathextract0则专门用于提取列表中的第一个匹配元素这意味着,当你的目标是一个单独的节点时,使用extract0显得更加精准在实际开发中,频繁操作的多是单一节点,因此extract0的使用频率更高为了简化理解和操作,Scrapy还额外提供了extract_first方法此方法在功能。

还没有评论,来说两句吧...