Stochastic Gradient Descent和Gradient Descent的主要区别在于数据点的选择和计算效率解释如下梯度下降法是一种用于优化损失函数的方法gradient区别,通过计算整个数据集上的损失函数的梯度来更新模型的参数这意味着在每一步的迭代中gradient区别,都会使用整个数据集来计算梯度,这种方法在数据集较大时非常耗时且计算资源消耗大gradient区别;在生态学的范畴内,空间异质性spatial heterogeneity是一个核心概念,它揭示了生态过程和格局在空间分布上的不均等性和复杂性这个术语的含义和运用广泛,涵盖了空间缀块性patchness和梯度gradient的综合特性空间缀块性,作为空间异质性的一个重要组成部分,着重于区分和分析不同类型的缀块gradient区别;至于随机利润的概率分布和随机最优控制问题,这些都与随机性密切相关,无论是quotstoct descentquot还是quotgradient descentquot,在解决这些问题时,都需要考虑不确定性因素,而quotstoct descentquot可能在处理这类随机问题时更具优势总的来说,quotstoct descentquot和quotgradient descentquot的主要区别在于前者更强调在随机性;适用性Gradient Boosting不仅适用于回归问题,也可以应用于分类和排名问题它通过优化残差和梯度,不断改进模型预测,从而在各种问题中都能取得良好的效果与AdaBoost的区别虽然Gradient Boosting与AdaBoost在本质上都是通过迭代构建弱模型并逐步增强组合成强模型,但它们在迭代过程中的具体实现和优化策略上;因为diff求差分函数求导函数,而gradient求梯度函数差分和梯度是两个不同的数学概念差分,又名差分函数或差分运算,是数学中的一个概念它将原函数fx 映射到fx+afx+b 差分运算,相应于微分运算,是微积分中重要的一个概念梯度是一个向量矢量,当某一函数在某点;Oblique adj 斜的不光明正大的 1James planted his flower garden with oblique rows of tulips 詹姆斯在花园里种了斜斜的几排郁金香2 From there, though, with the end of a ride that began almost three months ago looming, I slowed down and started on an oblique route home。

conicgradientconicgradient表示锥形渐变,虽然很实用,但是兼容性不是很好,所以一般用于移动端项目和后台项目中使用锥形渐变主要由3部分组成,包括起始角度中心位置角渐变断点,其中起始角度和中心位置都可以省略的角渐变断点的数据类型是ltangularcolorstoplist角渐变断点与线性渐变和径向;Grade的意思是1n产品材料的等级,品级官衔的级别职别成绩等级评分等级 2v按能力质量大小等将分级,分等,分类给评分给分数 Grade 读法 英 ɡre#618d 美 ɡre#618d短语1make the grade 成功达到标准 2ore grade 矿石品位分级;锥度和斜度都是用来描述物体或几何图形形状的参数,但它们的具体含义和应用场景有所不同首先,锥度Taper是指物体的两个端口的直径或宽度之间的差距,通常用于描述锥形物体的形状锥度可以分为正锥度和反锥度正锥度表示物体逐渐变细,而反锥度则相反,表示物体逐渐变粗其次,斜度Gradient是指;1stochastic gradient descent随机梯度下降 2gradient descent梯度下降 而stochastic随机 形容词 random随机, 任意, 乱, 随便, 轻淡, 胡乱的 stochastic随机 1Stochastic and mathematical models随机和数学模型2In this paper, a numerical method for structure stochastic response analysis is pr;两者意思差不多,但比较上gradient倾向是形容onedimensional物体例如图表中曲线的斜率,slope倾向是形容o or threedimensional物体例如平面或实物的斜率 gradient A rate of inclination a slope Mathematics A vector having coordinate ponents that are the partial derivatives of a function wi;切导斜度和切道斜度是在矿山开采过程中经常使用的两个术语,它们的区别如下1 切导斜度Ramp gradient切导斜度是指连接两个不同高度的平台或者开采面的斜坡的坡度在矿山开采中,为了方便运输设备和矿物,需要在不同高度的平台之间建造斜坡或者斜道,此时切导斜度就非常重要切导斜度的计算公式。

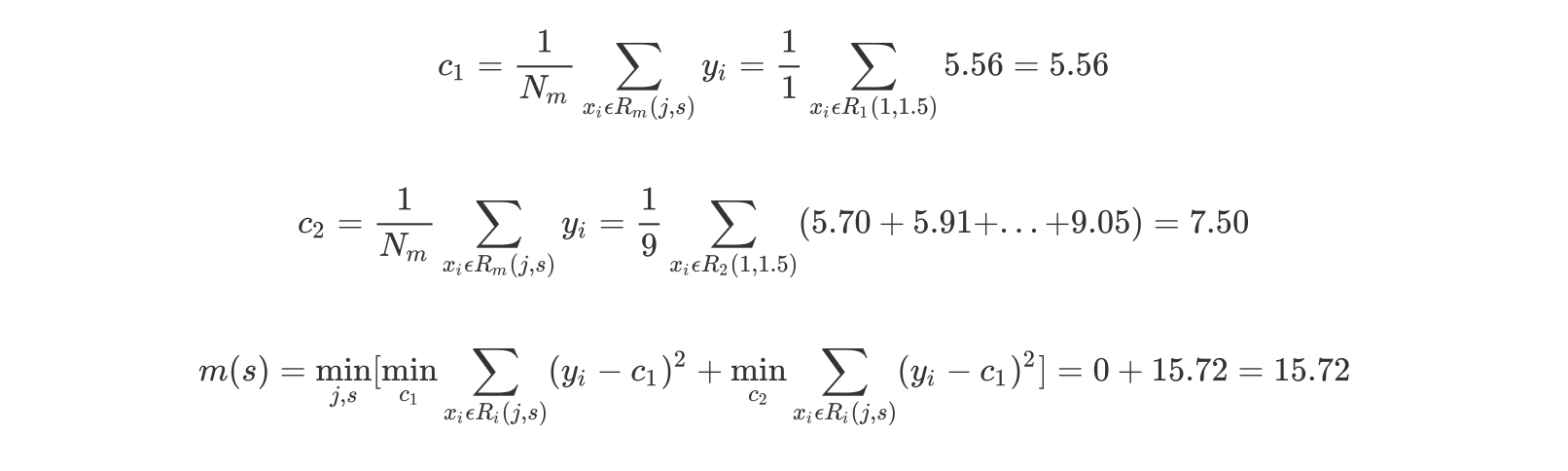

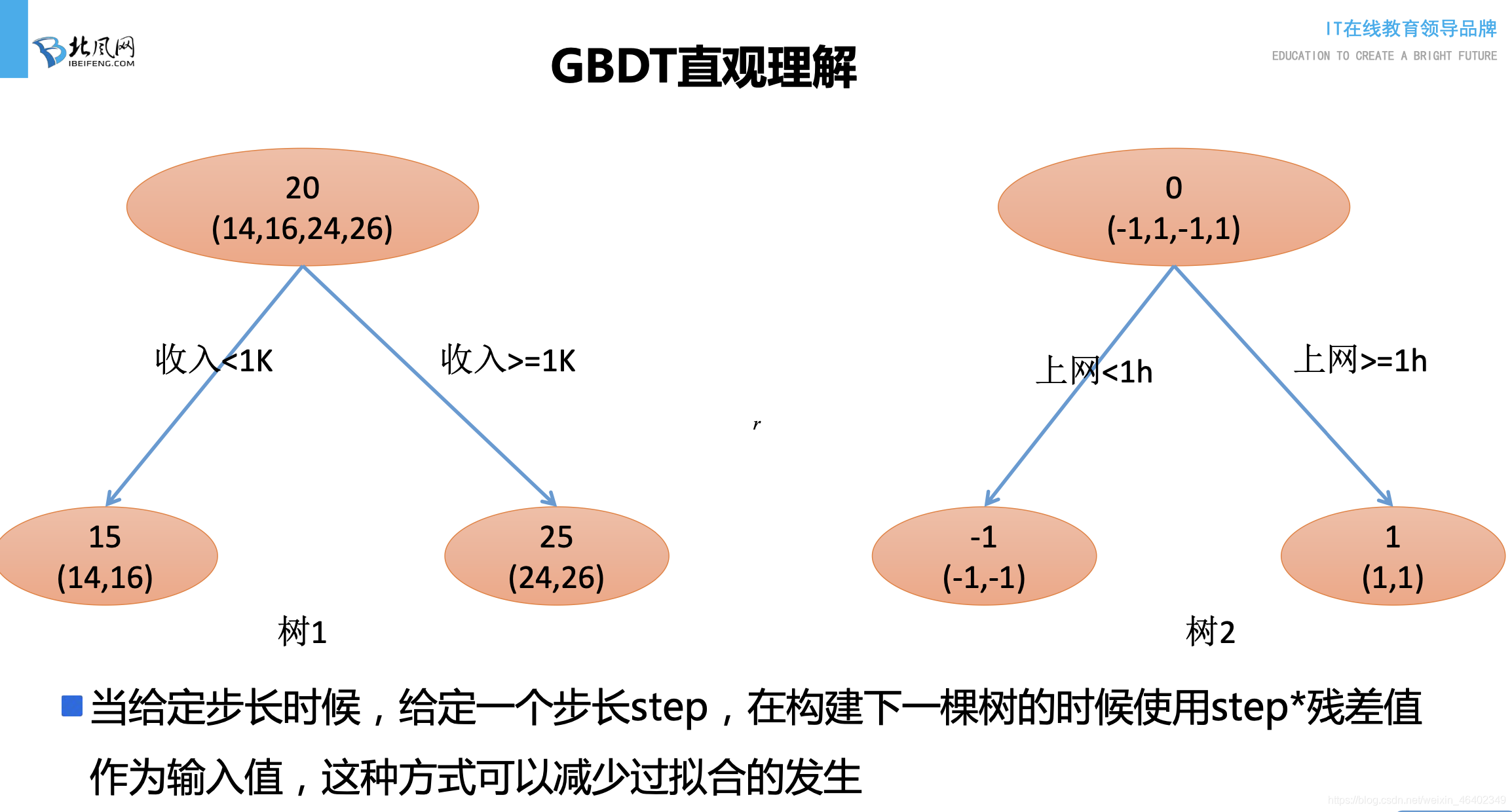

个人理解webkitgradientlinear 第一个参数为linear 时, 和webkitlineargradient没区别这里属于重复调用删除任意一个不影响;空间异质性,在生态学领域有着广泛的应用,其概念复杂而深刻它涵盖了空间缀块性patchiness和梯度gradient的综合效应缀块性强调的是不同区域类型及其分布的复杂关系,而异质性则更侧重于非均匀性它们之间虽有所区别,但共同点在于对非均质性和尺度依赖性的强调将这个概念应用到实际,gradient区别我们可以;是在之前建立的模型的损失函数的梯度下降方向, GB与Adaboost的区别在于AdaBoost是通过提升错分数据点的权重来定位模型的不足Gradient Boosting是通过算梯度gradient来定位模型的不足主要思想是,每一次建立单个学习器时,是在之前建立的模型的损失函数的梯度下降方向,损失函数越大,说明模型越容易。

具体地将,空间异质性一般可以理解为是空间缀块性patchness和梯度gradient的总和而缀块性则主要强调缀块的种类组成特征及其空间分布与配置的关系,比异质性在概念上更加具体因此,空间格局,异质性和缀块性在概念上和实际应用中都是相互联系,但又略有区别的一组概念最主要的共同典在于它们都;看似由最弱的基分类器聚合的模型反而开始展现出更高的性能参考资料CSCI 5525 Machine Learning Spring 2020 hands on machine learning 以上内容概要总结了AdaBoost和Gradient boosting两种集成学习方法的基本原理应用和性能特征,以及它们在实际应用中的区别和优劣。

还没有评论,来说两句吧...