1、PCA与KPCA二者都是降维kpcapca区别的算法kpcapca区别,PCA基于指标,KPCA基于样本应用PCA算法前提是假设存在一个线性超平面,进而投影如果数据不是线性,就需要KPCA,数据集从n 维映射到线性可分的高维Nn ,然后再从N 维降维到一个低维度,二者在特定变量相等。

2、KPCA核PCA结合了PCA和核技术,使用核函数映射非线性数据到高维空间后进行PCA降维这可以解决非线性数据映射问题,通过在高维空间下应用标准PCA实现降维LDA线性判别分析是一种特征抽取技术,旨在最大化类间差异和最小化类内差异,通过投影将数据分类任务简化LDA可以提高数据分析效率,降低过拟合。

3、KPCA在将数据映射到高维空间后,能够更好地区分不同类别的数据,提高了数据的可分性,擅长处理非线性数据,且具有更高的灵活性KPCA中的重要参数包括核函数和核函数参数,核函数用于将原始数据映射到高维空间,核函数参数影响了核函数变换的程度,通过交叉验证等方法可以确定最佳参数值降维后的维度需要根据。

4、而核主成分分析Kernel PCA,KPCA可实现数据的非线性降维,用于处理线性不可分的数据集kernel的选择有 #39linear#39, #39poly#39, #39rbf#39, #39sigmoid#39, #39cosine#39, #39precomputed#39,默认是#39linear#39 详细说明见官方说明,与普通的PCA差不多 SparsePCA 期望找到一组可以最优地重构数据的稀疏主成分稀疏性的大小由。

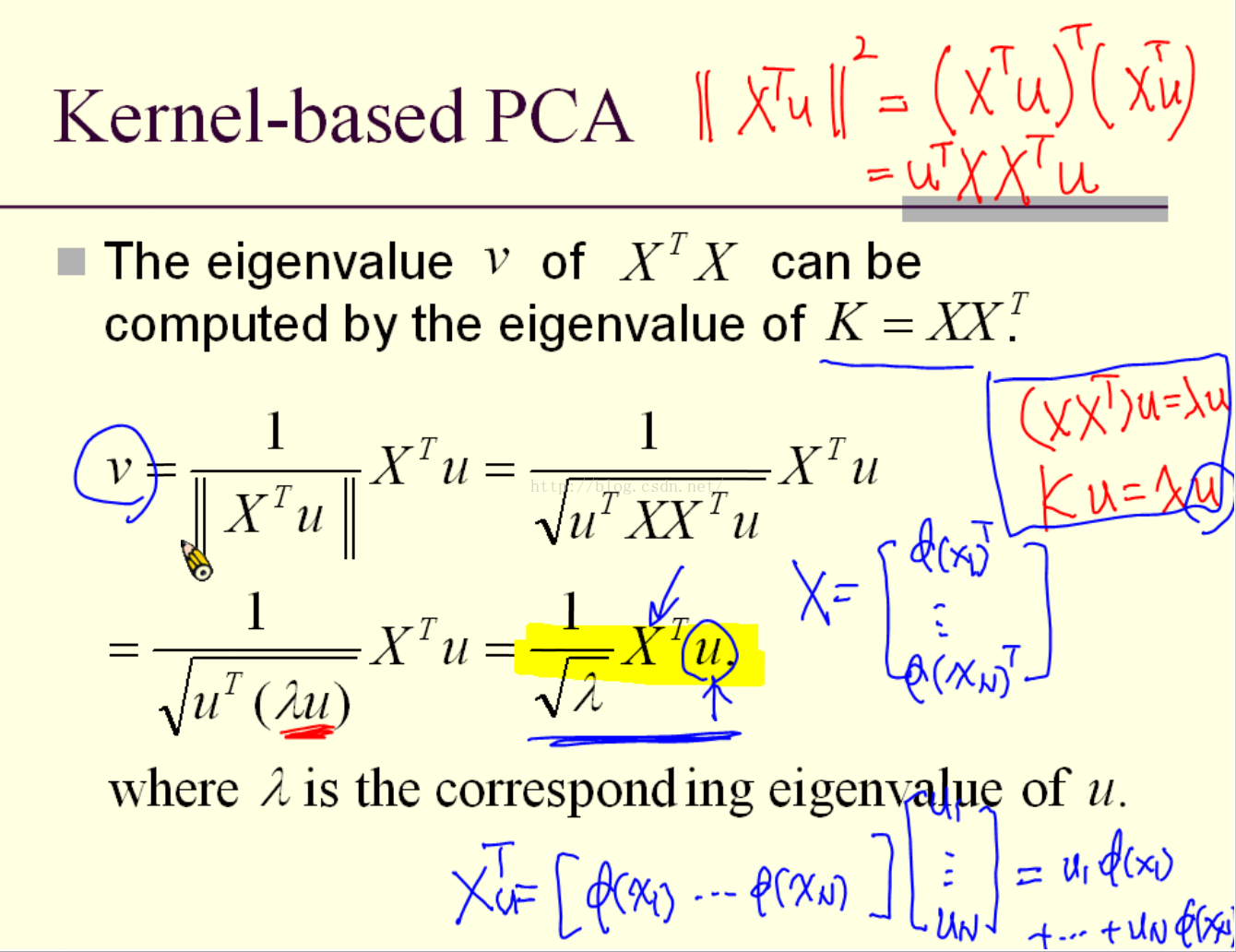

5、则对于n维空间的特征分解 映射为 通过在高维空间进行协方差矩阵的特征值分解,然后用和PCA一样的方法进行降维一般来说,映射#981不用显式的计算,而是在需要计算的时候通过核函数完成由于KPCA需要核函数的运算,因此它的计算量要比PCA大很多这里对PCA算法做一个总结作为一个非监督。

6、KPCA,但是由于人脸是非线性的,因而后面又出现了流形学习的算法ISOMAP目前最普遍的是主成分分析法PCA,具体有这些ICAPCA,PCA这种线性方法往往会丢失人脸上的许多非线性成分。

7、1 KPCA的建模流程 在KPCA中,kpcapca区别我们首先处理训练数据,构建核矩阵并进行中心化处理接着,通过特征值分解实现降维和特征提取,这对于故障检测至关重要例如,我们可以使用SPET2统计方法进行故障检测,帮助我们识别潜在问题2 数据重构的艺术 我们借鉴Scikitlearn的策略和文献2,提供数据重构的方法。

8、KPCA算法其实很简单,数据在低维度空间不是线性可分的,但是在高维度空间就可以变成线性可分的了利用这个特点,KPCA只是将原始数据通过核函数kernel映射到高维度空间,再利用PCA算法进行降维,所以叫做K PCA降维因此KPCA算法的关键在于这个核函数假设现在有映射函数φ不是核函数,它将数据从低。

9、KPCA分解步骤主要包括以下几个阶段1 计算核矩阵首先,KPCA算法通过选择一个合适的核函数来计算样本间的核矩阵这个核矩阵实际上反映了样本在高维特征空间中的相似度2 中心化核矩阵接下来,算法会对核矩阵进行中心化处理这一步骤是为了确保数据的均值为零,从而满足PCA处理的前提条件中心化。

10、具体来说,AKPCA是阿拉斯加初级保健协会的缩写词,其英文单词原形是quotAlaska Primary Care Associationquot在日常交流和专业文档中,AKPCA被广泛用于表示阿拉斯加地区提供初级医疗保健服务的组织其应用示例如在医疗报告行业会议或在线平台中引用该协会的相关信息了解AKPCA,不仅有助于我们快速识别和理解相关。

11、样本在经过映射通常是升维以后,本身它的维度就会发生很大变化,比如描述一个人,原来表示身高体重胸围等等这些特征经过升维以后不再具有物理意义,但是在分类过程中,升维可以把原本非线性的特征转化的较为接近线性,这就是核函数存在的价值kpcapca区别你原本特征维度是20,经过映射以后变成了500,后续的pca。

还没有评论,来说两句吧...